Déployer l'IA dans les applications mobiles, Web et intégrées

-

Sur l'appareil

Réduire la latence. Travailler hors connexion Protégez la confidentialité et la sécurité de vos données.

-

Multiplate-forme

Exécutez le même modèle sur Android, iOS, le Web et les applications intégrées.

-

Multi-framework

Compatible avec les modèles JAX, Keras, PyTorch et TensorFlow.

-

Pile complète d'IA en périphérie

Frameworks flexibles, solutions clés en main, accélérateurs matériels

Solutions prêtes à l'emploi et frameworks flexibles

API low-code pour les tâches d'IA courantes

API multiplates-formes pour traiter des tâches courantes d'IA générative, de vision, de texte et d'audio.

Premiers pas avec les tâches MediaPipeDéployer des modèles personnalisés multiplate-forme

Exécutez des modèles JAX, Keras, PyTorch et TensorFlow de manière performante sur Android, iOS, le Web et les appareils embarqués, optimisés pour le ML traditionnel et l'IA générative.

Premiers pas avec LiteRT

Accélérez les cycles de développement grâce à la visualisation

Visualisez la transformation de votre modèle via la conversion et la quantification. Déboguer les hotspots en superposant les résultats des benchmarks.

Premiers pas avec l'explorateur de modèles

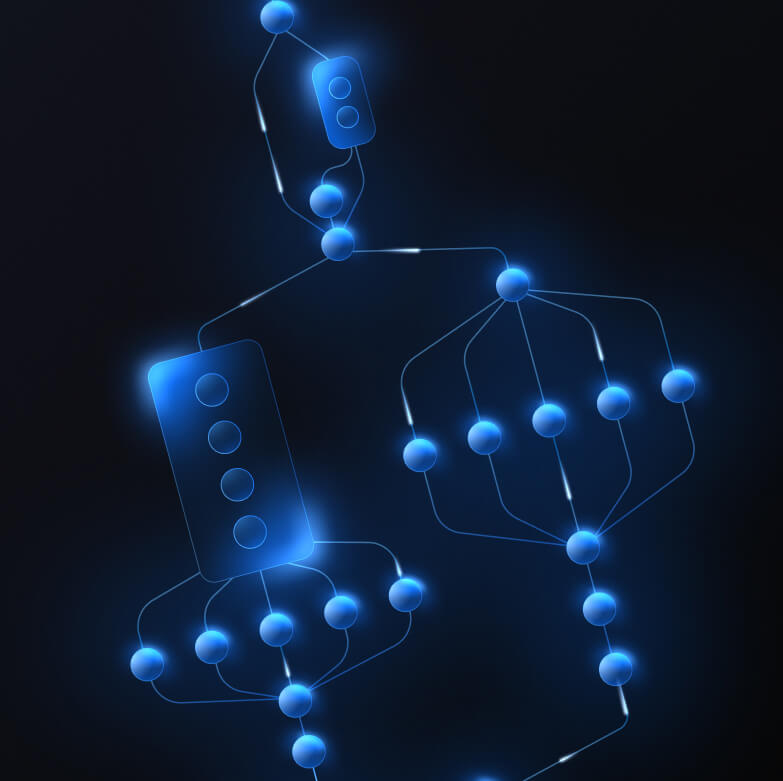

Créer des pipelines personnalisés pour des fonctionnalités de ML complexes

Créez votre propre tâche en enchaînant plusieurs modèles de ML avec une logique de pré et post-traitement de manière performante. Exécutez des pipelines accélérés (GPU et NPU) sans bloquer le processeur.

Premiers pas avec le framework MediaPipe

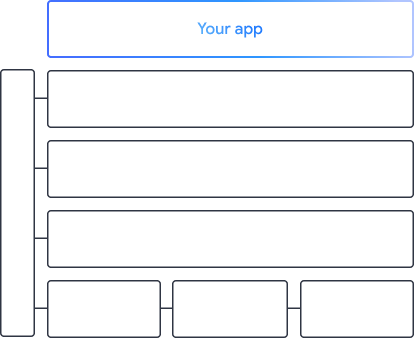

Les outils et frameworks qui alimentent les applications Google

Découvrez l'ensemble de la pile edge d'IA, avec des produits à tous les niveaux, des API low-code aux bibliothèques d'accélération spécifiques au matériel.

Tâches MediaPipe

Tâches MediaPipe

Intégrez rapidement des fonctionnalités d'IA dans des applications mobiles et Web à l'aide d'API low-code pour des tâches courantes couvrant l'IA générative, la vision par ordinateur, le texte et l'audio.

IA générative

Intégrez des modèles de langage et d'image génératifs directement dans vos applications à l'aide d'API prêtes à l'emploi.

Vision

Explorez un large éventail de tâches de vision couvrant la segmentation, la classification, la détection, la reconnaissance et les repères corporels.

Texte et audio

Classez du texte et de l'audio dans de nombreuses catégories, y compris la langue, l'opinion et vos propres catégories personnalisées.

Commencer

Framework MediaPipe

Framework MediaPipe

Framework de bas niveau utilisé pour créer des pipelines de ML accélérés hautes performances, qui incluent souvent plusieurs modèles de ML combinés à un prétraitement et un post-traitement.

LiteRT

LiteRT

Déployez des modèles d'IA créés dans n'importe quel framework sur les mobiles, le Web et les microcontrôleurs avec une accélération optimisée pour le matériel.

Multi-framework

Convertissez des modèles JAX, Keras, PyTorch et TensorFlow pour les exécuter en périphérie.

Multiplate-forme

Exécutez le même modèle exact sur Android, iOS, le Web et les microcontrôleurs avec des SDK natifs.

Légère et rapide

L'environnement d'exécution efficace de LiteRT ne prend que quelques mégaoctets et permet d'accélérer les modèles sur les processeurs, les GPU et les NPU.

Commencer

Explorateur de modèles

Explorateur de modèles

Explorez, déboguez et comparez vos modèles de manière visuelle. Superposez des benchmarks et des métriques de performances pour identifier les points chauds problématiques.

Gemini Nano dans Android et Chrome

Créer des expériences d'IA générative à l'aide du modèle sur l'appareil le plus puissant de Google