モバイル、ウェブ、組み込みアプリケーション全体に AI をデプロイする

-

デバイス

レイテンシを短縮します。オフラインで作業する。ローカルでデータを非公開に保つ。

-

クロス プラットフォーム

Android、iOS、ウェブ、組み込みで同じモデルを実行する。

-

マルチフレームワーク

JAX、Keras、PyTorch、TensorFlow の各モデルに対応。

-

完全な AI エッジスタック

柔軟なフレームワーク、ターンキー ソリューション、ハードウェア アクセラレータ

既製のソリューションと柔軟なフレームワーク

カスタムモデルをクロスプラットフォームでデプロイする

従来の ML と生成 AI 向けに最適化された JAX、Keras、PyTorch、TensorFlow モデルを、Android、iOS、ウェブ、組み込みデバイスで高パフォーマンスで実行します。

LiteRT を使ってみる

複雑な ML 特徴用のカスタム パイプラインを構築する

複数の ML モデルと前処理ロジックと後処理ロジックを効率的に連結して、独自のタスクを構築します。CPU でブロッキングすることなく、高速化された(GPU と NPU)パイプラインを実行します。

MediaPipe Framework の使用を開始する

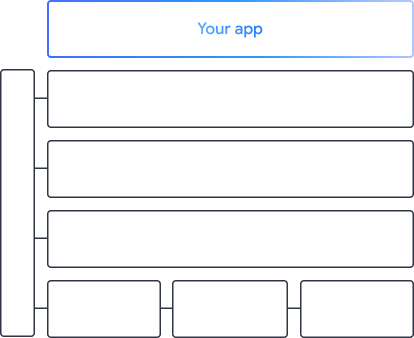

Google のアプリを支えるツールとフレームワーク

ローコード API からハードウェア固有のアクセラレーション ライブラリまで、あらゆるレベルのプロダクトを備えた AI エッジ スタック全体をご確認ください。

MediaPipe Tasks

MediaPipe Tasks

生成 AI、コンピュータ ビジョン、テキスト、音声にわたる一般的なタスクにローコード API を使用して、モバイルアプリとウェブアプリに AI 機能をすばやく構築します。

生成 AI

すぐに使用できる API を使用して、生成言語モデルと生成画像モデルをアプリに直接統合します。

Vision

セグメンテーション、分類、検出、認識、身体のランドマークにわたる幅広い画像タスクを探索します。

テキストと音声

言語、感情、独自のカスタム カテゴリなど、さまざまなカテゴリにテキストと音声を分類します。

MediaPipe フレームワーク

MediaPipe フレームワーク

高パフォーマンスの高速 ML パイプラインの構築に使用される低レベル フレームワーク。多くの場合、前処理と後処理を組み合わせた複数の ML モデルが含まれます。

LiteRT

LiteRT

任意のフレームワークで作成された AI モデルを、ハードウェア固有のアクセラレーションを最適化して、モバイル、ウェブ、マイクロコントローラにデプロイします。

マルチフレームワーク

JAX、Keras、PyTorch、TensorFlow のモデルを変換してエッジで実行します。

クロス プラットフォーム

ネイティブ SDK を使用して、Android、iOS、ウェブ、マイクロコントローラでまったく同じモデルを実行します。

軽量で高速

LiteRT の効率的なランタイムは数メガバイトしか使用せず、CPU、GPU、NPU 全体でモデルの高速化を可能にします。

モデル エクスプローラ

モデル エクスプローラ

モデルを視覚的に探索、デバッグ、比較します。パフォーマンスのベンチマークと数値をオーバーレイして、問題のあるホットスポットを特定します。

Android と Chrome の Gemini Nano

Google の最も強力なデバイス上のモデルを使用して生成 AI エクスペリエンスを構築する