Yapay zekayı mobil, web ve yerleşik uygulamalarda dağıtın

-

Cihazda

Gecikmeyi azaltın. Çevrimdışı çalışın. Verilerinizi yerel ve gizli tutun.

-

Platformlar arası

Aynı modeli Android, iOS, web ve yerleşik olarak çalıştırın.

-

Çok çerçeveli

JAX, Keras, PyTorch ve TensorFlow modelleriyle uyumludur.

-

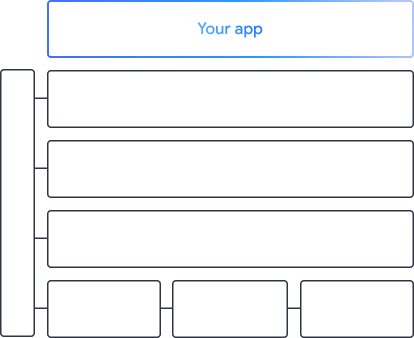

Tam yapay zeka uç yığını

Esnek çerçeveler, kullanıma hazır çözümler, donanım hızlandırıcılar

Hazır çözümler ve esnek çerçeveler

Yaygın yapay zeka görevleri için düşük kodlu API'ler

Üretken yapay zeka, görüntü, metin ve sesle ilgili yaygın görevlerin üstesinden gelmek için platformlar arası API'ler.

MediaPipe görevlerini kullanmaya başlamaÖzel modelleri platformlar arası dağıtma

Android, iOS, web ve yerleşik cihazlarda geleneksel makine öğrenimi ve üretken yapay zeka için optimize edilmiş JAX, Keras, PyTorch ve TensorFlow modellerini yüksek performansla çalıştırın.

LiteRT'yi kullanmaya başlama

Görselleştirmeyle geliştirme döngülerini kısaltın

Dönüşüm ve kesirli sayılaştırma yoluyla modelinizin dönüşümünü görselleştirin. Karşılaştırma sonuçlarını yer paylaşımı yaparak hotspot'larda hata ayıklama

Model Gezgini'ni kullanmaya başlama

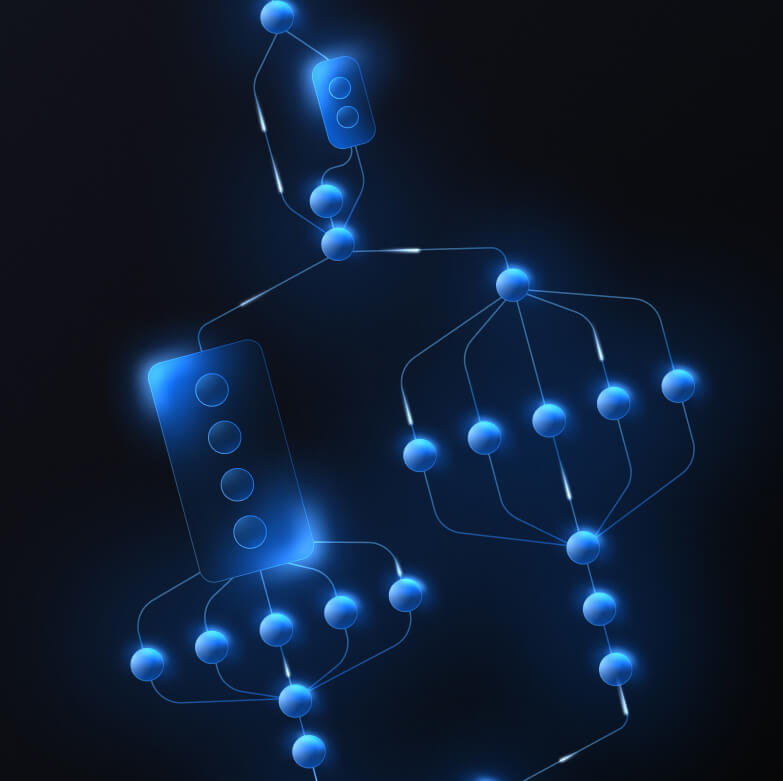

Karmaşık ML özellikleri için özel ardışık düzenler oluşturma

Önce ve sonra işleme mantığıyla birlikte birden fazla makine öğrenimi modelini performanslı bir şekilde zincirleyerek kendi görevinizi oluşturun. Hızlandırılmış (GPU ve NPU) ardışık düzenleri CPU'da engellemeden çalıştırın.

MediaPipe Framework'i kullanmaya başlama

Google'ın uygulamalarını destekleyen araçlar ve çerçeveler

Düşük kodlu API'lerden donanıma özel hızlandırma kitaplıklarına kadar her düzeyde ürün içeren tam yapay zeka uç katmanını keşfedin.

MediaPipe Görevleri

MediaPipe Görevleri

Üretken yapay zeka, bilgisayar görüşü, metin ve ses gibi yaygın görevler için basit kodlamayla API'leri kullanarak mobil ve web uygulamalarına yapay zeka özellikleri hızlıca ekleyin.

Üretken yapay zeka

Üretken dil ve resim modellerini, hazır API'ler ile doğrudan uygulamalarınıza entegre edin.

Görsel

Segmentasyon, sınıflandırma, algılama, tanıma ve vücut yer işaretlerini kapsayan çok çeşitli görüntüleme görevlerini keşfedin.

Metin ve ses

Metin ve sesi dil, duygu ve kendi özel kategorileriniz dahil olmak üzere birçok kategoriye göre sınıflandırın.

Başlayın

MediaPipe Framework

MediaPipe Framework

Genellikle ön ve son işleme ile birleştirilmiş birden fazla makine öğrenimi modeli içeren, yüksek performanslı hızlandırılmış makine öğrenimi ardışık düzenleri oluşturmak için kullanılan düşük düzey bir çerçeve.

LiteRT

LiteRT

Donanıma özel hızlandırmayı optimize ederek herhangi bir çerçevede oluşturulan yapay zeka modellerini mobil cihazlar, web ve mikrodenetleyicilerde dağıtın.

Çok çerçeveli

JAX, Keras, PyTorch ve TensorFlow'daki modelleri uçta çalıştırılacak şekilde dönüştürün.

Platformlar arası

Yerel SDK'larla aynı modeli Android, iOS, web ve mikrodenetleyicilerde çalıştırın.

Hafif ve hızlı

LiteRT'nin verimli çalışma zamanı yalnızca birkaç megabayt yer kaplar ve CPU, GPU ve NPU'larda model hızlandırma sağlar.

Başlayın

Model Gezgini

Model Gezgini

Modellerinizi görsel olarak keşfedin, hata ayıklayın ve karşılaştırın. Sorunlu yoğun noktaları belirlemek için performans karşılaştırmalarını ve sayısal verileri yer paylaşımı olarak gösterin.

Android ve Chrome'da Gemini Nano

Google'ın en güçlü cihaz üzerinde modelini kullanarak üretken yapay zeka deneyimleri oluşturun