1. Descripción general

Te damos la bienvenida al codelab de clasificación de texto con TensorFlow Lite y Firebase. En este codelab, aprenderás a usar TensorFlow Lite y Firebase para entrenar y, luego, implementar un modelo de clasificación de texto en tu app. Este codelab se basa en este ejemplo de TensorFlow Lite.

La clasificación de texto es el proceso de asignar etiquetas o categorías al texto según su contenido. Es una de las tareas fundamentales del procesamiento de lenguaje natural (PLN) con amplias aplicaciones, como el análisis de opiniones, el etiquetado de temas, la detección de spam y la detección de intención.

El análisis de opiniones es la interpretación y clasificación de las emociones (positivas, negativas y neutrales) en los datos de texto con técnicas de análisis de texto. El análisis de opiniones permite a las empresas identificar la opinión de los clientes sobre los productos, las marcas o los servicios en las conversaciones y los comentarios en línea.

En este instructivo, se muestra cómo compilar un modelo de aprendizaje automático para el análisis de opiniones, en particular, para clasificar el texto como positivo o negativo. Este es un ejemplo de clasificación binaria o de dos clases, un tipo de problema de aprendizaje automático importante y ampliamente aplicable.

Qué aprenderás

- Entrena un modelo de análisis de opiniones de TF Lite con Model Maker de TF Lite

- Implementa modelos de TF Lite en el AA de Firebase y accede a ellos desde tu app

- Haz un seguimiento de los comentarios de los usuarios para medir la precisión del modelo con Firebase Analytics

- Rendimiento del modelo de perfil a través de Firebase Performance Monitoring

- Selecciona cuál de los múltiples modelos implementados se carga a través de Remote Config

- Experimenta con diferentes modelos a través de Firebase A/B Testing

Requisitos

- Xcode 11 (o una versión posterior)

- CocoaPods 1.9.1 (o una versión posterior)

¿Cómo usarás este instructivo?

¿Cómo calificarías tu experiencia cuando compilas apps para Android?

2. Crea un proyecto en Firebase console

Agrega Firebase al proyecto

- Ve a Firebase console.

- Selecciona Create New Project y asigna el nombre "Firebase ML iOS Codelab" a tu proyecto.

3. Obtén el proyecto de muestra

Descargue el código

Para comenzar, clona el proyecto de muestra y ejecuta pod update en el directorio del proyecto:

git clone https://github.com/FirebaseExtended/codelab-textclassification-ios.git cd codelab-textclassification-ios pod install --repo-update

Si no tienes instalado git, también puedes descargar el proyecto de ejemplo desde su página de GitHub o haciendo clic en este vínculo. Una vez que hayas descargado el proyecto, ejecútalo en Xcode y experimenta con la clasificación de texto para comprender cómo funciona.

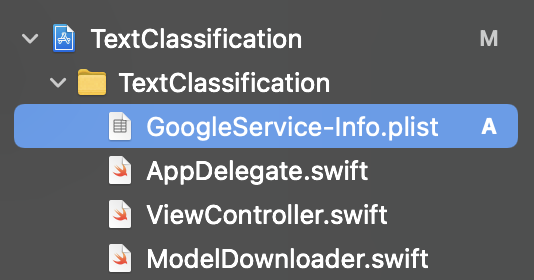

Configura Firebase

Sigue la documentación para crear un proyecto de Firebase nuevo. Una vez que tengas tu proyecto, descarga el archivo GoogleService-Info.plist del proyecto desde Firebase console y arrástralo a la raíz del proyecto de Xcode.

Agrega Firebase a tu Podfile y ejecuta pod install.

pod 'FirebaseMLModelDownloader', '9.3.0-beta'

En el método didFinishLaunchingWithOptions de tu AppDelegate, importa Firebase en la parte superior del archivo.

import FirebaseCore

Además, agrega una llamada para configurar Firebase.

FirebaseApp.configure()

Vuelve a ejecutar el proyecto para asegurarte de que la app esté configurada correctamente y no falle al iniciarse.

4. Entrena un modelo de análisis de opiniones

Usaremos Model Maker de TensorFlow Lite para entrenar un modelo de clasificación de texto que prediga el sentimiento de un texto determinado.

Este paso se presenta como un notebook de Python que puedes abrir en Google Colab.

Abrir en Colab

Después de completar este paso, tendrás un modelo de análisis de opiniones de TensorFlow Lite listo para implementarse en una app para dispositivos móviles.

5. Implementa un modelo en Firebase ML

Implementar un modelo en el AA de Firebase es útil por dos razones principales:

- Podemos mantener pequeño el tamaño de instalación de la app y descargar el modelo solo si es necesario.

- El modelo se puede actualizar periódicamente y con un ciclo de lanzamiento diferente al de toda la app.

El modelo se puede implementar a través de la consola o de forma programática con el SDK de Firebase Admin. En este paso, realizaremos la implementación a través de la consola.

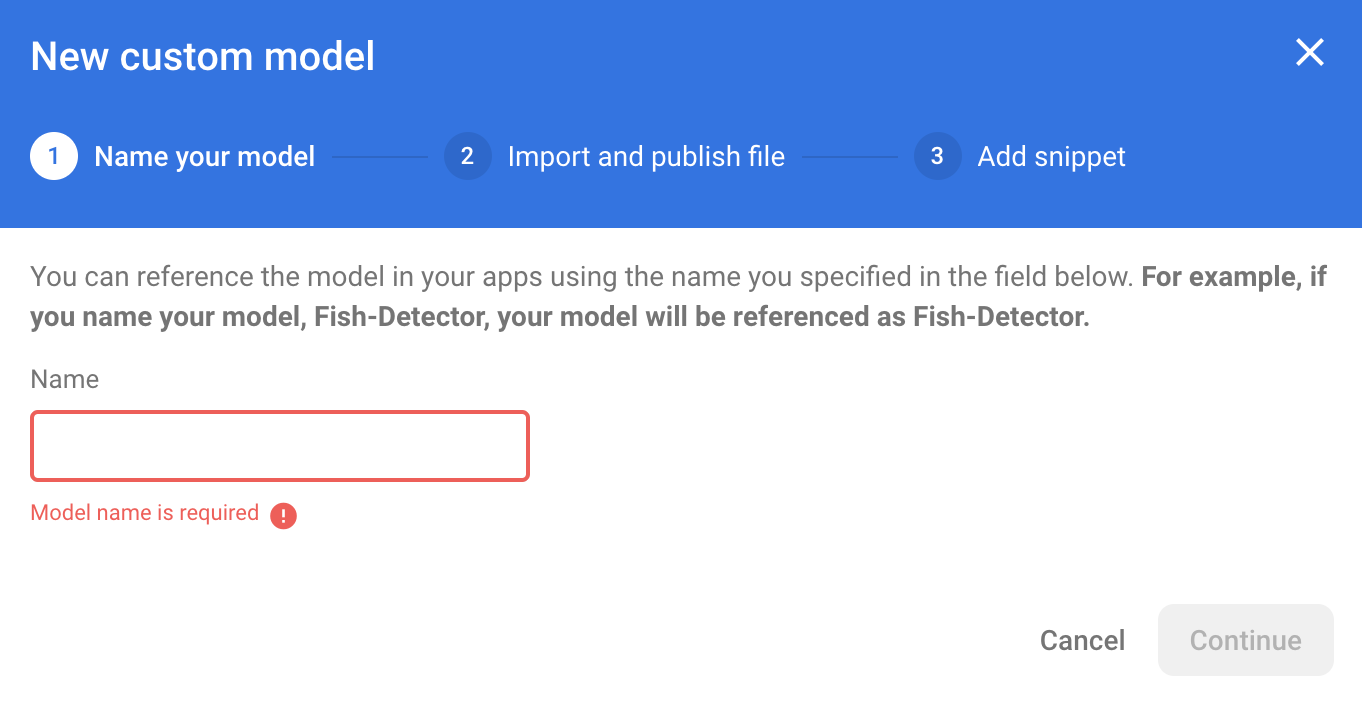

Primero, abre Firebase console y haz clic en Machine Learning en el panel de navegación izquierdo. Haz clic en “Comenzar” si es la primera vez que abres esta página. Luego, navega a "Personalizado" y haz clic en el botón "Agregar modelo".

Cuando se te solicite, asigna el nombre sentiment_analysis al modelo y sube el archivo que descargaste de Colab en el paso anterior.

6. Descarga el modelo del AA de Firebase

Elegir cuándo descargar el modelo remoto de Firebase en tu app puede ser complicado, ya que los modelos de TFLite pueden crecer relativamente mucho. Lo ideal es evitar cargar el modelo inmediatamente cuando se inicia la app, ya que, si nuestro modelo se usa para una sola función y el usuario nunca la usa, habremos descargado una cantidad significativa de datos sin motivo. También podemos establecer opciones de descarga, como recuperar modelos solo cuando se está conectado a Wi-Fi. Si quieres asegurarte de que el modelo esté disponible incluso sin conexión de red, es importante que también lo incluyas sin la app como copia de seguridad.

Para simplificar las cosas, quitaremos el modelo predeterminado incluido y siempre descargaremos un modelo de Firebase cuando la app se inicie por primera vez. De esta manera, cuando ejecutes el análisis de opiniones, podrás tener la certeza de que la inferencia se ejecuta con el modelo proporcionado por Firebase.

En la parte superior de ModelLoader.swift, importa el módulo de Firebase.

import FirebaseCore import FirebaseMLModelDownloader

Luego, implementa los siguientes métodos.

static func downloadModel(named name: String,

completion: @escaping (CustomModel?, DownloadError?) -> Void) {

guard FirebaseApp.app() != nil else {

completion(nil, .firebaseNotInitialized)

return

}

guard success == nil && failure == nil else {

completion(nil, .downloadInProgress)

return

}

let conditions = ModelDownloadConditions(allowsCellularAccess: false)

ModelDownloader.modelDownloader().getModel(name: name, downloadType: .localModelUpdateInBackground, conditions: conditions) { result in

switch (result) {

case .success(let customModel):

// Download complete.

// The CustomModel object contains the local path of the model file,

// which you can use to instantiate a TensorFlow Lite classifier.

return completion(customModel, nil)

case .failure(let error):

// Download was unsuccessful. Notify error message.

completion(nil, .downloadFailed(underlyingError: error))

}

}

}

En el método viewDidLoad de ViewController.swift, reemplaza la llamada a loadModel() por nuestro nuevo método de descarga de modelos.

// Download the model from Firebase

print("Fetching model...")

ModelLoader.downloadModel(named: "sentiment_analysis") { (customModel, error) in

guard let customModel = customModel else {

if let error = error {

print(error)

}

return

}

print("Model download complete")

// TODO: Initialize an NLClassifier from the downloaded model

}

Vuelve a ejecutar la app. Después de unos segundos, deberías ver un registro en Xcode que indica que el modelo remoto se descargó correctamente. Intenta escribir texto y confirma que el comportamiento de la app no haya cambiado.

7. Integra el modelo en tu app

La biblioteca de tareas de TensorFlow Lite te ayuda a integrar modelos de TensorFlow Lite en tu app con solo unas pocas líneas de código. Inicializaremos una instancia de TFLNLClassifier con el modelo de TensorFlow Lite descargado de Firebase. Luego, lo usaremos para clasificar la entrada de texto de los usuarios de la app y mostrar el resultado en la IU.

Agrega la dependencia

Ve al Podfile de la app y agrega TensorFlow Lite Task Library (Text) en las dependencias de la app. Asegúrate de agregar la dependencia debajo de la declaración target 'TextClassification'.

pod 'TensorFlowLiteTaskText', '~> 0.2.0'

Ejecuta pod install para instalar la nueva dependencia.

Inicializa un clasificador de texto

Luego, cargaremos el modelo de análisis de opiniones descargado de Firebase con NLClassifier de la biblioteca de tareas.

ViewController.swift

Declaremos una variable de instancia de TFLNLClassifier. En la parte superior del archivo, importa la nueva dependencia:

import TensorFlowLiteTaskText

Busca este comentario sobre el método que modificamos en el último paso:

// TODO: Add a TFLNLClassifier property.

Reemplaza el comentario TODO por el siguiente código:

private var classifier: TFLNLClassifier?

Inicializa la variable textClassifier con el modelo de análisis de opiniones descargado de Firebase. Busca este comentario que agregamos en el último paso:

// TODO: Initialize an NLClassifier from the downloaded model

Reemplaza el comentario TODO por el siguiente código:

let options = TFLNLClassifierOptions()

self.classifier = TFLNLClassifier.nlClassifier(modelPath: customModel.path, options: options)

Clasificar texto

Una vez que se haya configurado la instancia de classifier, puedes ejecutar el análisis de opiniones con una sola llamada al método.

ViewController.swift

En el método classify(text:), busca el comentario TODO:

// TODO: Run sentiment analysis on the input text

Reemplaza el comentario por el siguiente código:

guard let classifier = self.classifier else { return }

// Classify the text

let classifierResults = classifier.classify(text: text)

// Append the results to the list of results

let result = ClassificationResult(text: text, results: classifierResults)

results.append(result)

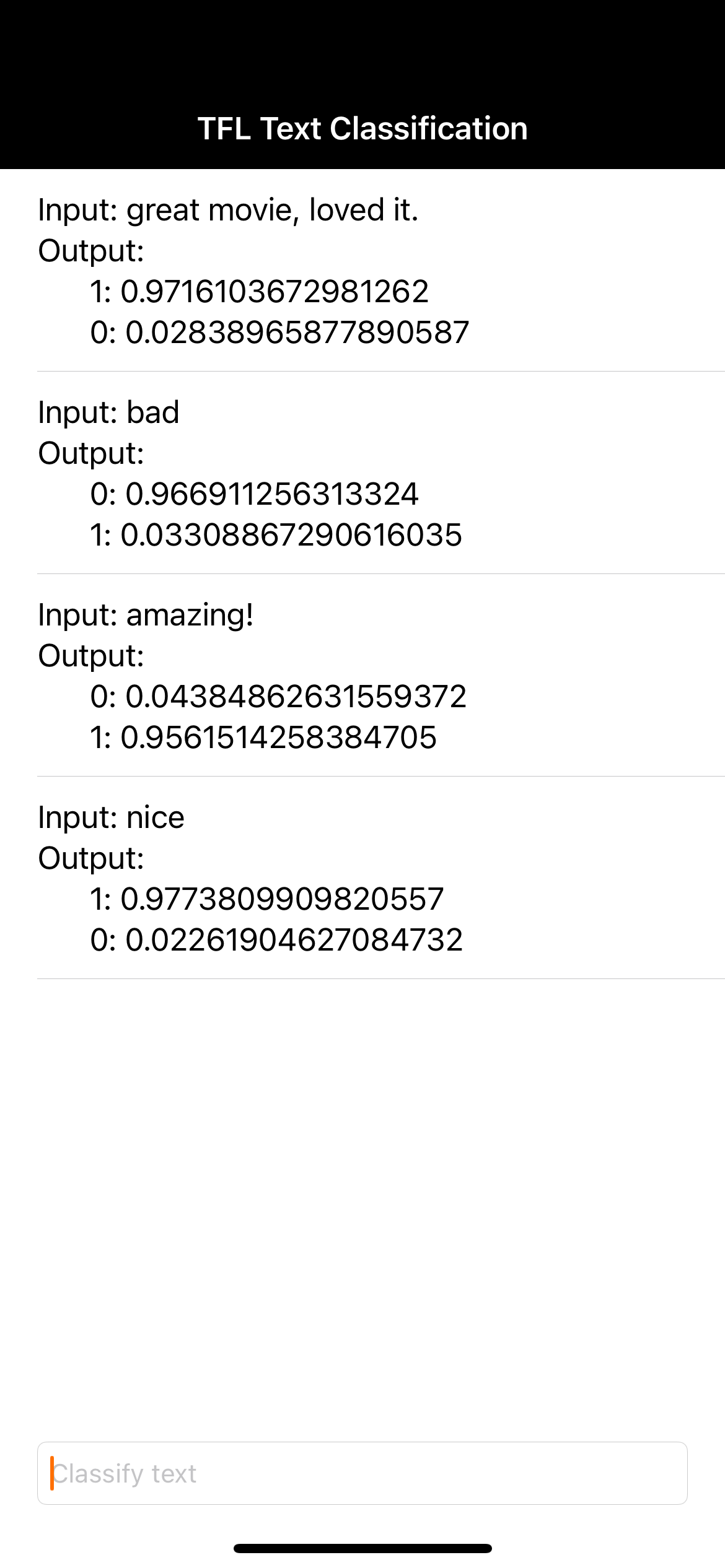

8. Ejecuta la app final

Ya integraste el modelo de análisis de opiniones en la app, así que probémoslo. Conecta tu dispositivo iOS y haz clic en Ejecutar (  ) en la barra de herramientas de Xcode.

) en la barra de herramientas de Xcode.

La app debería poder predecir correctamente la opinión de la reseña de película que ingreses.

9. Potencia la app con más funciones de Firebase

Además de alojar tus modelos de TFLite, Firebase proporciona otras funciones para potenciar tus casos de uso de aprendizaje automático:

- Firebase Performance Monitoring para medir la velocidad de inferencia del modelo que se ejecuta en el dispositivo de los usuarios

- Firebase Analytics para medir qué tan bien se desempeña tu modelo en producción a través de la medición de la reacción del usuario

- Firebase A/B Testing para probar varias versiones de tu modelo

- ¿Recuerdas que entrenamos dos versiones de nuestro modelo de TFLite anteriormente? Las pruebas A/B son una buena forma de averiguar qué versión tiene un mejor rendimiento en producción.

Para obtener más información sobre cómo aprovechar estas funciones en tu app, consulta los siguientes codelabs:

10. ¡Felicitaciones!

En este codelab, aprendiste a entrenar un modelo de TFLite de análisis de opiniones y a implementarlo en tu app para dispositivos móviles con Firebase. Para obtener más información sobre TFLite y Firebase, consulta otras muestras de TFLite y las guías de introducción de Firebase.

Temas abordados

- TensorFlow Lite

- AA de Firebase

Próximos pasos

- Mide la velocidad de inferencia de tu modelo con Firebase Performance Monitoring.

- Implementa el modelo desde Colab directamente en Firebase a través de la API de Firebase ML Model Management.

- Agrega un mecanismo para permitir que los usuarios envíen comentarios sobre el resultado de la predicción y usa Firebase Analytics para hacer un seguimiento de los comentarios de los usuarios.

- Realiza una prueba A/B del modelo de vectores de palabras promedio y del modelo de MobileBERT con Firebase A/B Testing.

Más información

- Documentación de Firebase Machine Learning

- Documentación de TensorFlow Lite

- Mide el rendimiento de la app con Firebase

- Modelos de pruebas A/B con Firebase