Sau khi huấn luyện một mô hình tuỳ chỉnh mới hoặc mô hình AutoML Vision Edge, bạn có thể sử dụng A/B Testing để xem mô hình mới hoạt động hiệu quả như thế nào trong điều kiện thực tế so với mô hình bạn đang sử dụng. Sau khi xác nhận rằng mô hình mới của mình là một điểm cải tiến, bạn có thể dễ dàng triển khai mô hình mới cho tất cả người dùng mà không cần yêu cầu cập nhật ứng dụng.

Trang này cho biết cách bạn có thể tiến hành thử nghiệm A/B để đánh giá hai phiên bản của một mô hình hỗ trợ tính năng tìm kiếm thực vật bằng hình ảnh giả định. Tính năng này sử dụng một mô hình gắn nhãn hình ảnh tuỳ chỉnh để giúp người dùng xác định các loài cây qua hình ảnh của chúng.

Giả sử bạn vừa phát hành một mô hình gắn nhãn cây mới, plant_labeler_v2 và bạn muốn chạy một thử nghiệm so sánh mô hình đó với mô hình hiện tại có tên là plant_labeler_v1. Các bước bên dưới cho biết cách thiết lập, chạy thử nghiệm và hành động dựa trên kết quả.

1. Định cấu hình mô hình từ xa

Bước đầu tiên để thử nghiệm A/B cho các mô hình là sửa đổi ứng dụng để sử dụng tham số Remote Config nhằm xác định mô hình mà ứng dụng sử dụng. Ban đầu, bạn sẽ đặt giá trị mặc định của tham số này thành mô hình mà ứng dụng của bạn đã sử dụng, nhưng vì tên mô hình được kiểm soát bằng một tham số có thể định cấu hình từ xa, nên bạn có thể thay đổi và thử nghiệm với nhiều mô hình mà không cần phải đẩy bản cập nhật ứng dụng cho người dùng mỗi khi cần.

Vì vậy, nếu đã phát hành mô hình hiện tại với tên plant_labeler_v1, thì trong mã khởi chạy ứng dụng, bạn sẽ đặt plant_labeler_v1 làm giá trị mặc định của tham số plant_labeler_model, như trong ví dụ sau:

Kotlin

val remoteConfig = FirebaseRemoteConfig.getInstance()

val remoteConfigDefaults = HashMap<String, Any>()

remoteConfigDefaults["plant_labeler_model"] = "plant_labeler_v1"

Tasks.await(remoteConfig.setDefaultsAsync(remoteConfigDefaults))

remoteConfig.fetchAndActivate().addOnSuccessListener { success ->

if (success) {

// Okay to get remote values.

// ...

}

}

Java

final FirebaseRemoteConfig remoteConfig = FirebaseRemoteConfig.getInstance();

Map<String, Object> remoteConfigDefaults = new HashMap<>();

remoteConfigDefaults.put("plant_labeler_model", "plant_labeler_v1");

Tasks.await(remoteConfig.setDefaultsAsync(remoteConfigDefaults));

remoteConfig.fetchAndActivate().addOnSuccessListener(

new OnSuccessListener<Boolean>() {

@Override

public void onSuccess(Boolean success) {

if (success) {

// Okay to get remote values.

// ...

}

}

});

Sau đó, hãy thay đổi mã thiết lập mô hình để tải mô hình do thông số plant_labeler_model chỉ định:

Kotlin

val rcValue = remoteConfig.getValue("plant_labeler_model")

val remoteModelName = rcValue.asString()

// ...

val remoteModel = FirebaseRemoteModel.Builder(remoteModelName)

.enableModelUpdates(true)

.setInitialDownloadConditions(initialConditions)

.setUpdatesDownloadConditions(updateConditions)

.build()

FirebaseModelManager.getInstance().registerRemoteModel(remoteModel)

// Optionally configure a local model:

// https://firebase.google.com/docs/ml/android/label-images-with-automl#configure-a-local-model-source

// https://firebase.google.com/docs/ml/android/use-custom-models#configure_a_local_model

Java

FirebaseRemoteConfigValue rcValue = remoteConfig.getValue("plant_labeler_model");

String remoteModelName = rcValue.asString();

// ...

FirebaseRemoteModel remoteModel = new FirebaseRemoteModel.Builder(remoteModelName)

.enableModelUpdates(true)

.setInitialDownloadConditions(initialConditions)

.setUpdatesDownloadConditions(updateConditions)

.build();

FirebaseModelManager.getInstance().registerRemoteModel(remoteModel);

// Optionally configure a local model:

// https://firebase.google.com/docs/ml/android/label-images-with-automl#configure-a-local-model-source

// https://firebase.google.com/docs/ml/android/use-custom-models#configure_a_local_model

Giờ đây, ứng dụng của bạn sử dụng tham số Remote Config để xác định mô hình nào sẽ tải, bạn có thể thay đổi mô hình chỉ bằng cách phát hành mô hình mới và gán tên của mô hình đó cho tham số Remote Config. Khả năng này cho phép A/B Testing chỉ định các mô hình khác nhau cho các người dùng khác nhau nhằm mục đích so sánh các mô hình đó.

Trước khi tiếp tục, hãy thêm nội dung sau vào mã tải mô hình xuống:

Kotlin

FirebaseModelManager.getInstance().downloadRemoteModelIfNeeded(remoteModel)

.addOnSuccessListener {

// If the model downloaded was specified by a remote parameter, log an

// event, which will be our experiment's activation event.

if (rcValue.source == FirebaseRemoteConfig.VALUE_SOURCE_REMOTE) {

FirebaseAnalytics.getInstance(this).logEvent("nondefault_model_downloaded", null)

}

}

Java

FirebaseModelManager.getInstance().downloadRemoteModelIfNeeded(remoteModel)

.addOnSuccessListener(new OnSuccessListener<Void>() {

@Override

public void onSuccess(Void aVoid) {

// If the model downloaded was specified by a remote parameter, log an

// event, which will be our experiment's activation event.

if (rcValue.getSource() == FirebaseRemoteConfig.VALUE_SOURCE_REMOTE) {

FirebaseAnalytics.getInstance(YourActivity.this)

.logEvent("nondefault_model_downloaded", null);

}

}

});

Mã trên ghi lại một sự kiện Analytics tuỳ chỉnh mà bạn sẽ sử dụng sau này làm

2. Xác định chỉ số mục tiêu

Bước tiếp theo là quyết định cách bạn sẽ đo lường mức độ thành công của mô hình và đảm bảo ứng dụng của bạn đang thu thập dữ liệu cần thiết để kiểm thử mức độ hiệu quả của các phiên bản mô hình theo chỉ số đó.

A/B Testing có một số chỉ số tích hợp, bao gồm doanh thu, mức độ tương tác hằng ngày và tỷ lệ giữ chân người dùng. Các chỉ số này thường hữu ích để kiểm thử nhiều luồng trải nghiệm người dùng hoặc tinh chỉnh các tham số, nhưng có thể không phù hợp để đánh giá mô hình và trường hợp sử dụng của bạn. Trong trường hợp này, bạn có thể thử tối ưu hoá cho một sự kiện tuỳ chỉnh của Analytics.

Lấy ví dụ về tính năng tìm kiếm thực vật bằng hình ảnh giả định, giả sử bạn trình bày kết quả tìm kiếm cho người dùng theo thứ tự độ tin cậy của mô hình đối với từng kết quả. Một cách để bạn có thể biết được độ chính xác của mô hình là bằng cách xem tần suất người dùng mở kết quả tìm kiếm đầu tiên.

Để kiểm tra xem mô hình nào đạt được mục tiêu tối đa hoá số lượt nhấp vào kết quả hàng đầu, bạn sẽ ghi lại một sự kiện tuỳ chỉnh mỗi khi người dùng nhấn vào mục đầu tiên trong danh sách kết quả.

Kotlin

FirebaseAnalytics.getInstance(this).logEvent("first_result_opened", null)

Java

FirebaseAnalytics.getInstance(YourActivity.this).logEvent("first_result_opened", null);

Cuối cùng, chỉ số mà bạn kiểm thử phụ thuộc vào cách ứng dụng sử dụng mô hình.

Tại thời điểm này, bạn có thể triển khai ứng dụng của mình lên Cửa hàng Play. Ứng dụng của bạn sẽ tiếp tục sử dụng mô hình ban đầu, nhưng mã Remote Config và Analytics mà bạn đã thêm sẽ cho phép bạn thử nghiệm với nhiều mô hình chỉ bằng cách sử dụng bảng điều khiển Firebase.

3. Chạy thử nghiệm A/B Testing

Giờ đây, ứng dụng của bạn đã được người dùng sử dụng và đang thu thập dữ liệu phân tích. Hãy tạo một thử nghiệm A/B Testing để kiểm tra hiệu quả của việc sử dụng mô hình mới thay vì mô hình hiện tại.

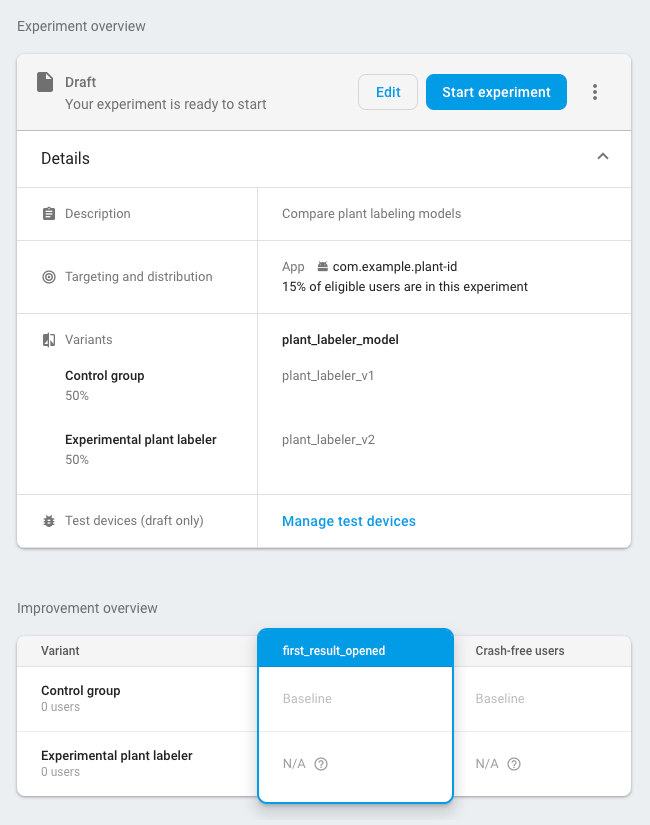

Cách tạo thử nghiệm:

-

Trên trang Sự kiện của bảng điều khiển Firebase, hãy xác minh rằng bạn đang ghi lại các sự kiện Analytics liên quan: sự kiện kích hoạt và chỉ số mục tiêu.

Ứng dụng của bạn cần ghi lại ít nhất một lần cho mỗi sự kiện trước khi sự kiện đó xuất hiện trong bảng điều khiển Firebase.

-

Trong bảng điều khiển Firebase, hãy mở mục A/B Testing.

-

Tạo thử nghiệm mới:

Nhấp vào Tạo thử nghiệm > Remote Config.

-

Trong mục Nhắm mục tiêu:

- Chọn ứng dụng của bạn trong danh sách

- Chỉ định số người dùng mà bạn muốn đưa vào thử nghiệm

- Chọn sự kiện kích hoạt mà bạn đã bắt đầu ghi nhật ký (trong ví dụ này là nondefault_model_downloaded)

-

Trong phần Mục tiêu, hãy chọn chỉ số mục tiêu mà bạn đã xác định trong phần trước (trong ví dụ này là first_result_opened) từ danh sách chỉ số mục tiêu và chọn bất kỳ chỉ số nào khác mà bạn muốn theo dõi, chẳng hạn như doanh thu từ giao dịch mua hoặc số người dùng không gặp sự cố.

-

Trong phần Biến thể, hãy xác định hai biến thể:

- Nhóm đối chứng (được tạo tự động)

- Trình gắn nhãn cây thử nghiệm

Đối với Nhóm điều khiển, hãy tạo một tham số

plant_labeler_modelvà đặt tham số đó thànhplant_labeler_v1. Người dùng được chỉ định cho nhóm đối chứng sẽ sử dụng mô hình cũ. (Đừng đặt tham số thành(no change), vì trong ứng dụng, bạn đang kiểm thử rằng bạn đang sử dụng một giá trị từ xa.)Đối với biến thể Máy gắn nhãn cây thử nghiệm, hãy đặt tham số

plant_labeler_modelthànhplant_labeler_v2(giả sử bạn đã xuất bản mô hình mới của mình theo tên đó). Người dùng được chỉ định cho biến thể này sẽ sử dụng mô hình mới.

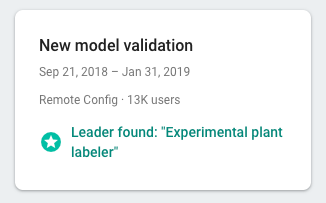

Bắt đầu thử nghiệm và để thử nghiệm chạy trong vài ngày hoặc lâu hơn, cho đến khi A/B Testing khai báo một người dẫn đầu. Nếu thử nghiệm không thể xác định người dẫn đầu, bạn có thể cần mở rộng thử nghiệm cho nhiều người dùng hơn.

4. Triển khai biến thể chiến thắng cho tất cả người dùng

Sau khi A/B Testing thu thập đủ thông tin để khai báo một biến thể hàng đầu (trong trường hợp này là biến thể giúp tăng tối đa số lượt nhấp vào kết quả tìm kiếm hàng đầu), bạn có thể quyết định triển khai biến thể chiến thắng (hoặc một biến thể khác) cho tất cả người dùng.

Trong mục A/B Testing của bảng điều khiển Firebase, hãy mở chế độ xem chi tiết của thử nghiệm đã hoàn tất. Trong chế độ xem này, bạn có thể xem hiệu suất của từng biến thể theo chỉ số mục tiêu và mọi chỉ số phụ mà bạn đã chọn. Với thông tin này, bạn có thể quyết định triển khai biến thể hàng đầu hay một biến thể khác.

Để triển khai một biến thể cho tất cả người dùng, hãy nhấp vào more_vert > Triển khai biến thể trên trang chi tiết của thử nghiệm. Sau khi bạn thực hiện việc này, giá trị của tham số plant_labeler_model sẽ là plant_labeler_v2 cho tất cả người dùng.

Trong bản cập nhật ứng dụng trong tương lai, bạn nên thay đổi giá trị mặc định của thông số plant_labeler_model thành plant_labeler_v2 và cập nhật mô hình đi kèm nếu bạn sử dụng mô hình đó. Tuy nhiên, người dùng của bạn đang sử dụng mô hình mới nhất, vì vậy, bạn có thể đẩy bản cập nhật này vào ứng dụng đã phát hành bất cứ khi nào thuận tiện, chẳng hạn như khi bạn thực hiện bản cập nhật tính năng tiếp theo.