Modele generatywne są bardzo przydatne do rozwiązywania wielu typów problemów. Są one jednak ograniczone przez takie czynniki jak:

- Po trenowaniu są zamrażane, co prowadzi do nieaktualnej wiedzy.

- Nie mogą wysyłać zapytań do danych zewnętrznych ani ich modyfikować.

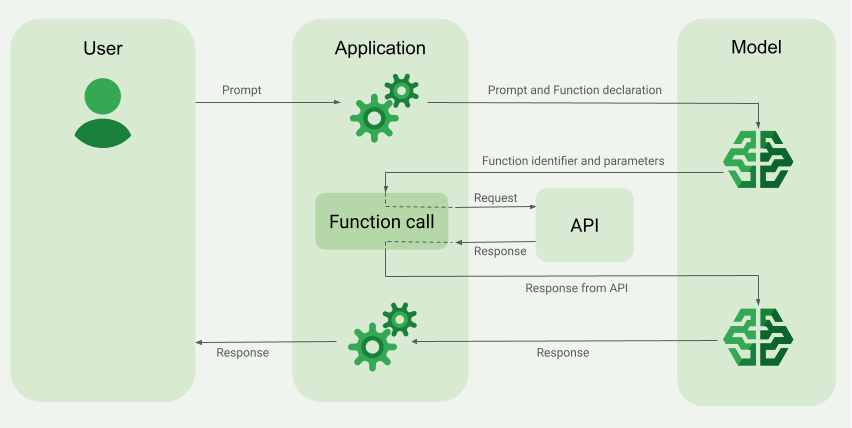

Wywołania funkcji mogą pomóc w pokonywaniu niektórych z tych ograniczeń. Funkcja wywoływania jest czasami nazywana używaniem narzędzia, ponieważ pozwala modelowi korzystać z zewnętrznych narzędzi, takich jak interfejsy API i funkcje, do generowania ostatecznej odpowiedzi.

Więcej informacji o wywoływaniu funkcji znajdziesz w dokumentacji Google Cloud, w tym przydatną listę przypadków użycia wywołania funkcji.

Tryb wywoływania funkcji jest obsługiwany przez wszystkie modele Gemini (z wyjątkiem modeli Gemini 1.0).

Z tego przewodnika dowiesz się, jak zaimplementować konfigurację wywołania funkcji podobną do przykładu opisanego w następnej głównej sekcji tej strony. Ogólnie rzecz biorąc, tak skonfigurujesz wywoływanie funkcji w aplikacji:

Napisz funkcję, która może dostarczyć modelowi informacji potrzebnych do wygenerowania ostatecznej odpowiedzi (funkcja może na przykład wywołać zewnętrzny interfejs API).

Utwórz deklarację funkcji, która opisuje funkcję i jej parametry.

Podaj deklarację funkcji podczas inicjalizacji modelu, aby model wiedział, jak w razie potrzeby z niej korzystać.

Skonfiguruj aplikację tak, aby model mógł przesłać wymagane informacje, które pozwolą aplikacji wywołać funkcję.

Przekaż odpowiedź funkcji z powrotem do modelu, aby mógł wygenerować ostateczną odpowiedź.

Przykład wywołania funkcji

Wysyłając żądanie do modelu, możesz też przekazać mu zestaw „narzędzi” (np. funkcji), których może użyć do wygenerowania ostatecznej odpowiedzi. Aby korzystać z tych funkcji i je wywoływać (czyli „wywoływać funkcje”), model i aplikacja muszą wymieniać się informacjami. Dlatego zalecany sposób wywoływania funkcji to interfejs czatu wielostronnego.

Wyobraź sobie, że masz aplikację, w której użytkownik może wpisać taki komunikat:

What was the weather in Boston on October 17, 2024?.

Modele Gemini mogą nie znać tych informacji o pogodzie. Wyobraź sobie jednak, że znasz zewnętrzny interfejs API usługi pogodowej, który może je udostępnić. Możesz użyć wywołania funkcji, aby umożliwić modelowi Gemini dostęp do tego interfejsu API i jego informacji o pogodzie.

Najpierw w aplikacji piszesz funkcję fetchWeather, która współpracuje z tym hipotetycznym zewnętrznym interfejsem API i ma te dane wejściowe i wyjściowe:

| Parametr | Typ | Wymagany | Opis |

|---|---|---|---|

| Dane wejściowe | |||

location |

Obiekt | Tak | Nazwa miasta i stanu, dla których ma być sprawdzana pogoda. Obsługiwane są tylko miasta w Stanach Zjednoczonych. Musi być zawsze zagnieżdżonym obiektem typu city lub state.

|

date |

Ciąg znaków | Tak | Data, dla której ma być pobierana pogoda (musi być zawsze w formacie YYYY-MM-DD).

|

| Wyniki | |||

temperature |

Liczba całkowita | Tak | Temperatura (w stopniach Fahrenheita) |

chancePrecipitation |

Ciąg znaków | Tak | Prawdopodobieństwo opadów (wyrażone w procentach) |

cloudConditions |

Ciąg znaków | Tak | Warunki Cloud (jeden z tych: clear, partlyCloudy,

mostlyCloudy, cloudy)

|

Podczas inicjowania modelu informujesz go, że istnieje funkcja fetchWeatheri jak można jej używać do przetwarzania przychodzących żądań (jeśli to konieczne).

Jest to tzw. „deklaracja funkcji”. Model nie wywołuje funkcji bezpośrednio. Gdy model przetwarza przychodzące żądanie, decyduje, czy funkcja fetchWeather może pomóc mu w odpowiedzi na to żądanie. Jeśli model uzna, że funkcja może być przydatna, wygeneruje uporządkowane dane, które pomogą Twojej aplikacji wywołać tę funkcję.

Ponownie spójrz na przychodzące żądanie:

What was the weather in Boston on October 17, 2024?. Model prawdopodobnie zdecyduje, że funkcja fetchWeather może pomóc w wygenerowaniu odpowiedzi. Model sprawdziłby, jakie parametry wejściowe są potrzebne do funkcji fetchWeather, a następnie wygenerowałby uporządkowane dane wejściowe dla tej funkcji, które wyglądałyby mniej więcej tak:

{

functionName: fetchWeather,

location: {

city: Boston,

state: Massachusetts // the model can infer the state from the prompt

},

date: 2024-10-17

}

Model przekazuje te uporządkowane dane wejściowe do aplikacji, aby mogła ona wywołać funkcję fetchWeather. Gdy aplikacja otrzyma warunki pogodowe z interfejsu API, przekaże te informacje do modelu. Te informacje o pogodzie umożliwiają modelowi dokończenie końcowego przetwarzania i wygenerowanie odpowiedzi na początkowe żądanie What was the weather in Boston on October 17, 2024?

Model może podać ostateczną odpowiedź w języku naturalnym, np.:

On October 17, 2024, in Boston, it was 38 degrees Fahrenheit with partly cloudy skies.

Implementacja wywoływania funkcji

Zanim zaczniesz

Jeśli jeszcze tego nie zrobisz, zapoznaj się z przewodnikiem wprowadzającym do pakietów SDK Vertex AI in Firebase. Najpierw wykonaj te czynności:

Skonfiguruj nowy lub istniejący projekt Firebase, w tym użyj abonamentu Blaze i włącz wymagane interfejsy API.

Połącz aplikację z Firebase, w tym zarejestruj ją i dodaj do niej konfigurację Firebase.

Dodaj pakiet SDK i zainicjuj usługę Vertex AI oraz model generatywny w swojej aplikacji.

Po połączeniu aplikacji z Firebase, dodaniu pakietu SDK i inicjalizacji usługi Vertex AI oraz modelu generatywnego możesz wywołać funkcję Gemini API.

Pozostałe kroki w tym przewodniku pokazują, jak zaimplementować konfigurację wywołania funkcji podobną do omówionej w sekcji Omówienie przykładu wywołania funkcji (patrz górna część tej strony).

Pełny przykładowy kod tego wywołania funkcji znajdziesz dalej na tej stronie.

Krok 1. Napisz funkcję

Wyobraź sobie, że masz aplikację, w której użytkownik może wpisać taki komunikat:

What was the weather in Boston on October 17, 2024?. Modele Gemini mogą nie znać tych informacji o pogodzie. Załóżmy jednak, że znasz zewnętrzny interfejs API usługi pogodowej, który może je udostępnić. Przykłady w tym przewodniku korzystają z tego hipotetycznego zewnętrznego interfejsu API.

W aplikacji napisz funkcję, która będzie współpracować z hipotetycznym zewnętrznym interfejsem API, i przekaż modelowi informacje potrzebne do wygenerowania ostatecznego żądania. W tym przykładzie pogody będzie to funkcja fetchWeather, która wykonuje wywołanie do tego hipotetycznego zewnętrznego interfejsu API.

// This function calls a hypothetical external API that returns

// a collection of weather information for a given location on a given date.

func fetchWeather(city: String, state: String, date: String) -> JSONObject {

// TODO(developer): Write a standard function that would call an external weather API.

// For demo purposes, this hypothetical response is hardcoded here in the expected format.

return [

"temperature": .number(38),

"chancePrecipitation": .string("56%"),

"cloudConditions": .string("partlyCloudy"),

]

}

Krok 2. Utwórz deklarację funkcji

Utwórz deklarację funkcji, którą później przekażesz modelowi (następny krok w tym przewodniku).

W deklaracji podaj jak najwięcej szczegółów w opisach funkcji i jej parametrów.

Model korzysta z informacji w deklaracji funkcji, aby określić, którą funkcję wybrać i jak podać wartości parametrów dla rzeczywistego wywołania funkcji. Aby dowiedzieć się, jak model może wybierać funkcje i jak możesz kontrolować ten wybór, przeczytaj dodatkowe zachowania i opcje dalej na tej stronie.

Pamiętaj o tych kwestiach dotyczących przesłanego schematu:

Deklaracje funkcji muszą być podane w formacie schematu zgodnym z schematem OpenAPI. Vertex AI obsługuje schemat OpenAPI w ograniczonym zakresie.

Obsługiwane są te atrybuty:

type,nullable,required,format,description,properties,items,enum.Te atrybuty nie są obsługiwane:

default,optional,maximum,oneOf.

Domyślnie w SDK Vertex AI in Firebase wszystkie pola są uważane za wymagane, chyba że w tablicy

optionalPropertieszostaną określone jako opcjonalne. W przypadku tych opcjonalnych pól model może wypełnić pola lub je pominąć. Pamiętaj, że jest to przeciwieństwo domyślnego zachowania funkcji Vertex AI Gemini API.

Sprawdzone metody związane z deklaracjami funkcji, w tym wskazówki dotyczące nazw i opisów, znajdziesz w dokumentacji Google Cloud w sekcji Sprawdzone metody.

Oto jak napisać deklarację funkcji:

let fetchWeatherTool = FunctionDeclaration(

name: "fetchWeather",

description: "Get the weather conditions for a specific city on a specific date.",

parameters: [

"location": .object(

properties: [

"city": .string(description: "The city of the location."),

"state": .string(description: "The US state of the location."),

],

description: """

The name of the city and its state for which to get the weather. Only cities in the

USA are supported.

"""

),

"date": .string(

description: """

The date for which to get the weather. Date must be in the format: YYYY-MM-DD.

"""

),

]

)

Krok 3. Podaj deklarację funkcji podczas inicjalizacji modelu

Maksymalna liczba deklaracji funkcji, które możesz podać w prośbie, to 128. Więcej informacji o tym, jak model może wybierać funkcje, a także jak możesz kontrolować ten wybór (za pomocą toolConfig do ustawienia trybu wywoływania funkcji), znajdziesz w sekcji Dodatkowe zachowania i opcje na tej stronie.

import FirebaseVertexAI

// Initialize the Vertex AI service and the generative model.

let model = VertexAI.vertexAI().generativeModel(

modelName: "gemini-2.0-flash",

// Provide the function declaration to the model.

tools: [.functionDeclarations([fetchWeatherTool])]

)

Dowiedz się, jak wybrać model i opcjonalnie lokalizację odpowiednią do przypadku użycia i aplikacji.

Krok 4. Wywołaj funkcję, aby wywołać zewnętrzny interfejs API.

Jeśli model uzna, że funkcja fetchWeather może mu pomóc w wygenerowaniu ostatecznej odpowiedzi, aplikacja musi wywołać tę funkcję, korzystając ze strukturyzowanych danych wejściowych dostarczonych przez model.

Informacje muszą być przekazywane między modelem a aplikacją, dlatego zalecamy używanie wywoływania funkcji za pomocą interfejsu czatu wieloetapowego.

Ten fragment kodu pokazuje, jak aplikacja jest informowana, że model chce użyć funkcji fetchWeather. Pokazuje też, że model podał niezbędne wartości parametrów wejściowych do wywołania funkcji (i powiązanego z nim zewnętrznego interfejsu API).

W tym przykładzie żądanie przychodzące zawierało prompt What was the weather in Boston on October 17, 2024?. Na podstawie tego prompta model wywnioskował parametry wejściowe wymagane przez funkcję fetchWeather (czyli city, state i date).

let chat = model.startChat()

let prompt = "What was the weather in Boston on October 17, 2024?"

// Send the user's question (the prompt) to the model using multi-turn chat.

let response = try await chat.sendMessage(prompt)

var functionResponses = [FunctionResponsePart]()

// When the model responds with one or more function calls, invoke the function(s).

for functionCall in response.functionCalls {

if functionCall.name == "fetchWeather" {

// TODO(developer): Handle invalid arguments.

guard case let .object(location) = functionCall.args["location"] else { fatalError() }

guard case let .string(city) = location["city"] else { fatalError() }

guard case let .string(state) = location["state"] else { fatalError() }

guard case let .string(date) = functionCall.args["date"] else { fatalError() }

functionResponses.append(FunctionResponsePart(

name: functionCall.name,

// Forward the structured input data prepared by the model

// to the hypothetical external API.

response: fetchWeather(city: city, state: state, date: date)

))

}

// TODO(developer): Handle other potential function calls, if any.

}

Krok 5. Przekaż wyjście funkcji do modelu, aby wygenerować ostateczną odpowiedź

Gdy funkcja fetchWeather zwróci informacje o pogodzie, aplikacja musi przekazać je do modelu.

Następnie model wykonuje ostatnie przetwarzanie i generuje ostateczną odpowiedź w języku naturalnym, np.:

On October 17, 2024 in Boston, it was 38 degrees Fahrenheit with partly cloudy skies.

// Send the response(s) from the function back to the model

// so that the model can use it to generate its final response.

let finalResponse = try await chat.sendMessage(

[ModelContent(role: "function", parts: functionResponses)]

)

// Log the text response.

print(finalResponse.text ?? "No text in response.")

Dodatkowe zachowania i opcje

Oto kilka dodatkowych zachowań wywoływania funkcji, które musisz uwzględnić w kodze, oraz opcje, którymi możesz zarządzać.

Model może poprosić o ponowne wywołanie funkcji lub innej funkcji.

Jeśli odpowiedzi z jednego wywołania funkcji nie wystarczają do wygenerowania ostatecznej odpowiedzi, model może poprosić o dodatkowe wywołanie funkcji lub wywołanie zupełnie innej funkcji. Może się to zdarzyć tylko wtedy, gdy w deklaracji funkcji w liście funkcji podasz więcej niż jedną funkcję.

Aplikacja musi uwzględniać fakt, że model może poprosić o dodatkowe funkcje.

Model może wywołać wiele funkcji jednocześnie.

Na liście deklaracji funkcji, którą przekazujesz modelowi, możesz podać maksymalnie 128 funkcji. W związku z tym model może uznać, że do wygenerowania ostatecznej odpowiedzi potrzebne są różne funkcje. Może też zdecydować się wywołać niektóre z tych funkcji jednocześnie – nazywa się to równoległym wywoływaniem funkcji.

Aplikacja musi uwzględniać fakt, że model może jednocześnie wykonywać wiele funkcji, a także przekazywać modelowi wszystkie odpowiedzi z tych funkcji.

Możesz kontrolować, czy i w jaki sposób model może prosić o wywołanie funkcji.

Możesz określić, czy i w jaki sposób model ma używać podanych deklaracji funkcji. Jest to tzw. ustawienie trybu wywoływania funkcji. Oto przykłady:

Zamiast pozwalać modelowi na wybór między natychmiastową odpowiedzią w naturalnym języku a wywołaniem funkcji, możesz zmusić go do zawsze używania wywołań funkcji. Jest to tzw. wymuszone wywołanie funkcji.

Jeśli podasz kilka deklaracji funkcji, możesz ograniczyć model do korzystania tylko z podzbioru podanych funkcji.

Te ograniczenia (czyli tryby) wdrażasz, dodając konfigurację narzędzia (toolConfig) wraz z promptem i deklaracjami funkcji. W konfiguracji narzędzia możesz wybrać jeden z tych trybów. Najbardziej przydatny tryb to ANY.

| Tryb | Opis |

|---|---|

AUTO |

Domyślne zachowanie modelu. Model decyduje, czy użyć wywołania funkcji czy odpowiedzi w języku naturalnym. |

ANY |

Model musi używać wywołań funkcji („wymuszone wywołanie funkcji”). Aby ograniczyć model do podzbioru funkcji, w polu allowedFunctionNames podaj dozwolone nazwy funkcji.

|

NONE |

Model nie może używać wywołań funkcji. Takie działanie jest równoważne żądaniu modelu bez żadnych powiązanych deklaracji funkcji. |

Co jeszcze możesz zrobić?

Wypróbuj inne możliwości Gemini API

- tworzyć rozmowy wieloetapowe (czat);

- generować tekst na podstawie promptów tekstowych,

- generować tekst na podstawie promptów multimodalnych (w tym tekst, obrazy, pliki PDF, filmy i pliki audio).

Dowiedz się, jak kontrolować generowanie treści

- Poznaj projektowanie promptów, w tym sprawdzone metody, strategie i przykładowe prompty.

- Skonfiguruj parametry modelu, takie jak temperatura i maksymalna liczba tokenów wyjściowych (w przypadku Gemini) lub format obrazu i generowanie osób (w przypadku Imagen).

- Używaj ustawień bezpieczeństwa, aby dostosować prawdopodobieństwo otrzymywania odpowiedzi, które mogą być uważane za szkodliwe.

Więcej informacji o obsługiwanych modelach

Dowiedz się więcej o modelach dostępnych w różnych przypadkach użycia oraz o ich limitach i cenach.Prześlij opinię na temat korzystania z usługi Vertex AI in Firebase